Europese AI-Act: veilige, eerlijke en transparante AI-systemen

De EU wil Artificial Intelligence (AI) systemen reguleren middels de EU-AI-Act. De regelgeving richt zich vooral op het versterken van regels rondom datakwaliteit, transparantie, menselijk toezicht en verantwoording. De wetgeving moet begin 2024 van kracht worden. In onderstaand artikel wil ik in het kort de werking uitleggen voor bedrijven en overheden die AI-toepassingen willen ontwikkelen of verkopen.

Doel van de AI-Act

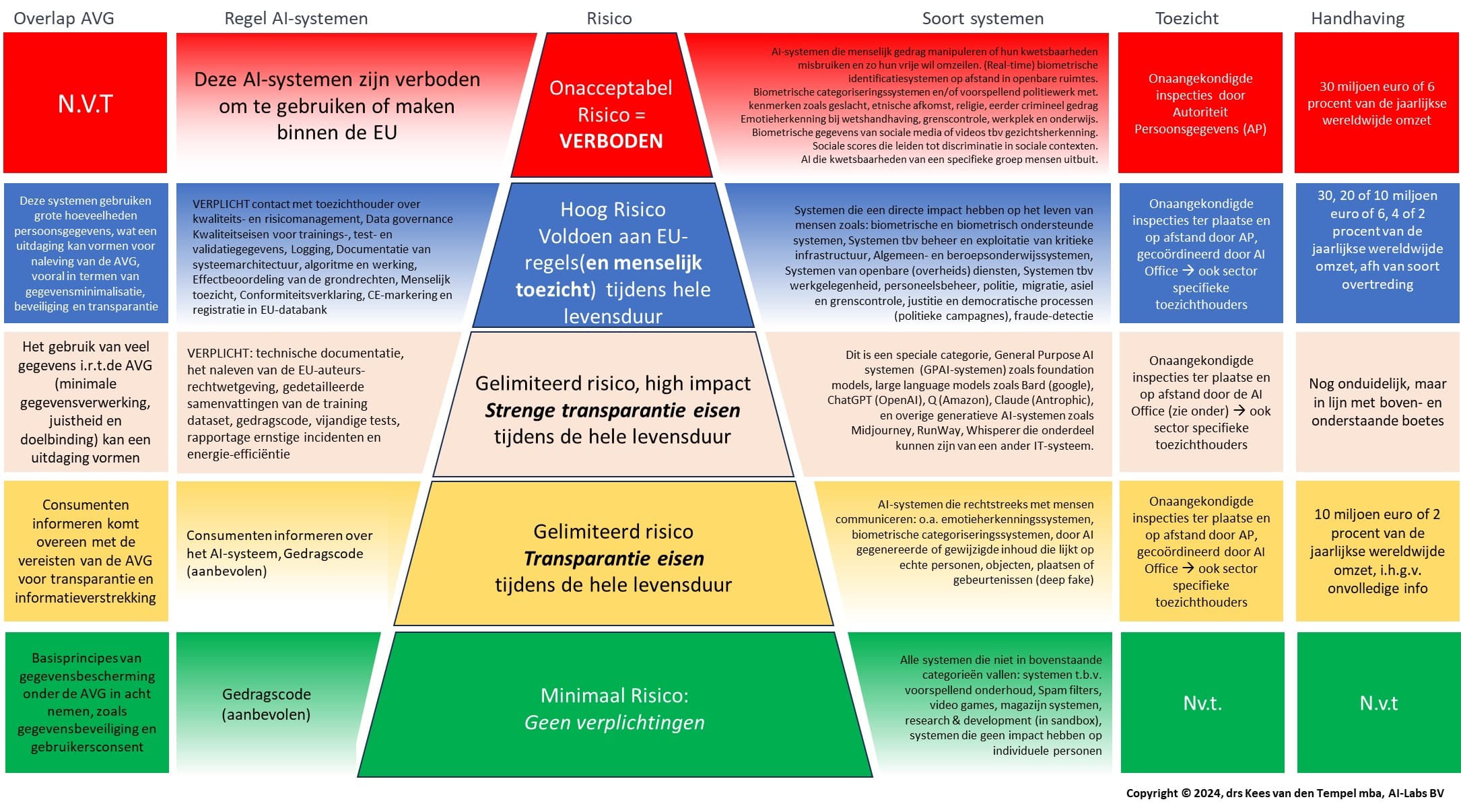

Met de AI-Act wil Europa ervoor zorgen dat AI-systemen veilig, transparant, traceerbaar, niet-discriminerend en milieuvriendelijk zijn. Deze doelstellingen worden vaak aangeduid met de termen Explainable AI en Responsible AI (klik hier voor uitleg). Elke systeem wat aan de EU-AI-Act voldoet mag het CE-keurmerk voeren. De regelgeving geldt ook voor AI-systemen uit de rest van de wereld die in Europa gebruikt worden. Zie hieronder alle zaken op een rijtje: (klik hier om een PDF-versie te downloaden)

Risico gebaseerde classificatie

Bovenstaande doelen hoopt men te bereiken door AI-systemen te classificeren op basis van het risico dat ze vormen via vier risiconiveaus:

- Onaanvaardbaar risico: AI-systemen die een duidelijke bedreiging voor de veiligheid, het levensonderhoud en de rechten van mensen vormen zijn verboden. Denk hierbij aan predictive policing, sociale scoring (wat in China wel gebeurt) tot aan speelgoed dat met behulp van spraakhulp dat gevaarlijk gedrag aanmoedigt.

- Hoog risico systemen: Dit zijn AI-systemen die een flinke impact hebben op de levensloop van mensen zoals student-onderwijssystemen, burger-overheidssystemen, kritieke-infrastructuur-systemen, biometrische identificatiesystemen op afstand (uitzondering voor o.a. antiterrorisme, vermiste personen), etc. Deze systemen moet voldoen aan regelgeving zoals risicobeoordeling en beperking, kwaliteit van de dataset, volledige documentatie van het algoritme en logging van gebruik en menselijk toezicht. De overhead bij de ontwikkeling van deze AI-systemen is fors.

- Beperkt risico, high impact systemen heeft betrekking op AI-systemen voor algemene toepassing, zoals large language modellen (ChatGPT, Bard) en overige (vaak generatieve) AI systemen (Midjourney, Dall-e) die onderdeel kunnen vormen van andere softwaretoepassingen. Fabrikanten en leveranciers moeten voldoen aan strenge transparantieverplichtingen waaronder de Europese richtlijnen voor auteursrecht, veel opener zijn over de gebruikte trainingsdata en aantonen hoeveel energie het algoritme gebruikt.

- Beperkt risico systemen heeft betrekking op AI-systemen met specifieke transparantieverplichtingen. Bij het gebruik van AI-systemen social media moeten gebruikers zich ervan bewust zijn dat ze communiceren met een machine c.q. algoritme. Ook deep-fake apps vallen hier onder. Dus fabrikanten moeten transparantie aantonen t.a.v. de gebruikte data en algoritmes.

- Minimaal of geen risico: deze AI-applicaties vormen de meeste AI-systemen. Voorbeelden zijn onder meer spamfilters, videogames met AI en voorraadbeheersystemen. Deze systemen hoeven aan geen enkele AI-regelgeving te voldoen.

Toezicht en handhaving

Toezicht en handhaving vindt plaats op het AI-systeem en de gebruikte dataset (ook tijdens gebruik) door self-assessments. Voor high-risk AI-toepassingen is het verplicht om de algemene toezichthouder en de sectorspecifieke toezichthouder te betrekken. De eerste algemene toezichthouder is een land-specifieke toezichthouder (zoals Autoriteit Persoonsgegevens). Stel je ontwikkelt een AI-systeem voor de gezondheidszorg dan heb je te maken met sector-specifieke toezichthouders, zoals de Inspectie Gezondheidszorg en Jeugd en/of de Nederlandse Zorgautoriteit (NZa). Verder worden de volgende toezichthoudende instanties vanuit Europa in het leven geroepen:- Het “AI-Office” (in oprichting) controleert de meest geavanceerde AI-modellen en draagt bij tot de bevordering van normen en testpraktijken en handhaaft de gemeenschappelijke regels van alle lidstaten.

- Het “scientific panel of independent experts” ondersteunt het AI-Office over GPAI models en foundation models

- De “AI-Board”, bestaat uit vertegenwoordigers van de lidstaten en zal fungeren als coördinatieplatform en adviesorgaan voor de Europese Commissie en zal de lidstaten een belangrijke rol toekennen bij de uitvoering van de verordening

- Het “Adviesforum” worden opgericht voor belanghebbenden zoals branchevertegenwoordigers, start-ups, het maatschappelijk middenveld en de academische wereld, dat het AI-Board van technische expertise voorziet.

De primaire verantwoordelijkheid voor een AI-systeem zal worden gedragen door de "aanbieders" van AI-systemen; echter, er zullen echter ook bepaalde verantwoordelijkheden worden toegewezen aan distributeurs en importeurs van AI-halffabricaten (zoals b.v. bij LLM foudation models). Maar ook gebruikers kunnen de werking van AI-toepassingen beïnvloeden door b.v. op social media een specifiek onderwerp te zoeken. Het recommending systeem zal daar automatisch op reageren en dit onderwerp hoog op de tijdlijn van een gebruiker zetten. De AI-Act stelt dat ook in dit geval de aanbieder transparant is over de werking.

Overlap tussen de AI-Act en AVG

De AI-Act en de Algemene Verordening Gegevensbescherming (AVG) overlappen op verschillende belangrijke punten, vooral in het kader van de bescherming van persoonsgegevens en de transparantie van AI-systemen:- Privacybescherming: Beide regelgevingen leggen nadruk op de bescherming van persoonlijke gegevens en privacy van individuen.

- Transparantievereisten: Ze vereisen beide dat gebruikers duidelijk geïnformeerd worden over hoe hun gegevens worden gebruikt en verwerkt.

- Gegevensbeheer: Zowel de AI-Act als de AVG benadrukken het belang van zorgvuldig gegevensbeheer, inclusief de toestemming van de gebruiker en het recht op inzage en verwijdering van gegevens.

- Toezicht en verantwoording: Beide stellen eisen aan toezicht en verantwoording, waarbij organisaties verantwoordelijk zijn voor de naleving van de regelgeving en de bescherming van gebruikersrechten.

- Ethische Richtlijnen: De regelgevingen bevatten richtlijnen voor ethisch gebruik van gegevens en AI-technologieën, zoals niet-discriminatie en eerlijkheid.

Zowel de Europese AI-Act als de AVG (Algemene Verordening Gegevensbescherming) vereisen de uitvoering van een Data Protection Impact Assessment (DPIA), wat aangeeft dat ze overeenkomsten hebben in de manier waarop ze risico's benaderen. In de aanpak van een DPIA kunnen dan ook de krachten gebundeld worden. Dit samenwerkingsverband tussen de twee regelgevingen zorgt voor een robuuster kader voor ethische en verantwoorde ontwikkeling en implementatie van AI-technologieën in Europa.

Overwegingen

De opzet van de EU-AI-Act is groot en complex en de totstandkoming is een stevig politiek proces. Top bedrijven zijn bang dat de regelgeving te streng is: https://edition.cnn.com/2023/06/30/tech/eu-companies-risks-ai-law-intl-hnk/index.html. Top wetenschappers zoals Andrew Ng zijn bang dat wetgevers te weinig verstand hebben van AI om goede regelgeving te maken: https://www.deeplearning.ai/the-batch/what-lawmakers-need-to-know-about-ai/. Zeker nu de technische ontwikkelingen zo enorm snel gaan.

Het grootste deel van het werk om een goedkeuring te krijgen, komt terecht bij de ontwikkelaars die hun AI-code moeten documenteren, op een manier die ook nog eens begrijpelijk voor de gebruiker is. Daarom is het belangrijk om als organisatie eerst AI-richtlijnen op te stellen. Ook is het belangrijk voor organisatie om AI niet alleen als bedreiging te benaderen, maar zeker ook als kans en de technische en juridische sandbox te gebruiken: dit is een onderdeel in de Europese AI-Act om innovatie te stimuleren.

Onze aanpak

AI-Labs biedt expertise en diensten rondom de implementatie van de Europese AI-Act, die zich richt op veilige, eerlijke en transparante AI-systemen. Voor klanten betekent dit ondersteuning bij het ontwikkelen, en implementeren van AI-toepassingen die voldoen aan strenge eisen op het gebied van datakwaliteit, transparantie, menselijk toezicht en verantwoording, waarbij de naleving van de nieuwe regelgeving centraal staat. Onze aanpak kenmerkt zich door een op-maat traject. Hierbij werken we samen met diverse advocaten kantoren die gespecialiseerd zijn op dit onderwerp.